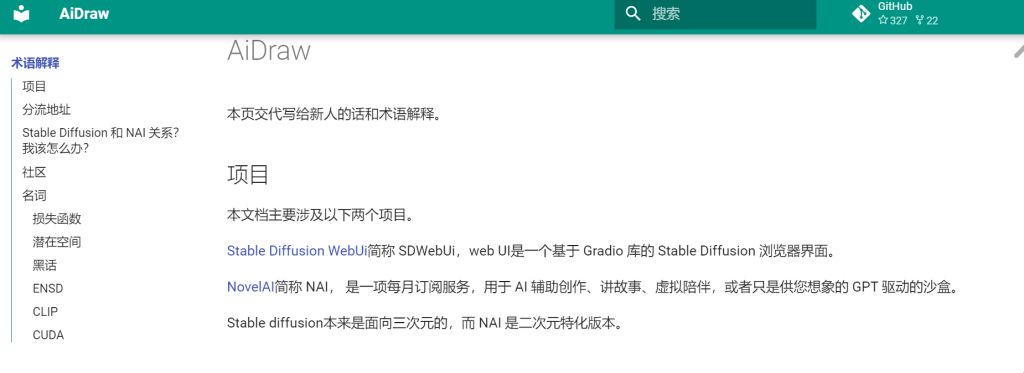

![图片[1]-NovelAI泄露原版前后端部署教程-皑雪](https://www.ixacg.top/wp-content/uploads/2022/10/ccc33072e3213303-1024x586.jpg)

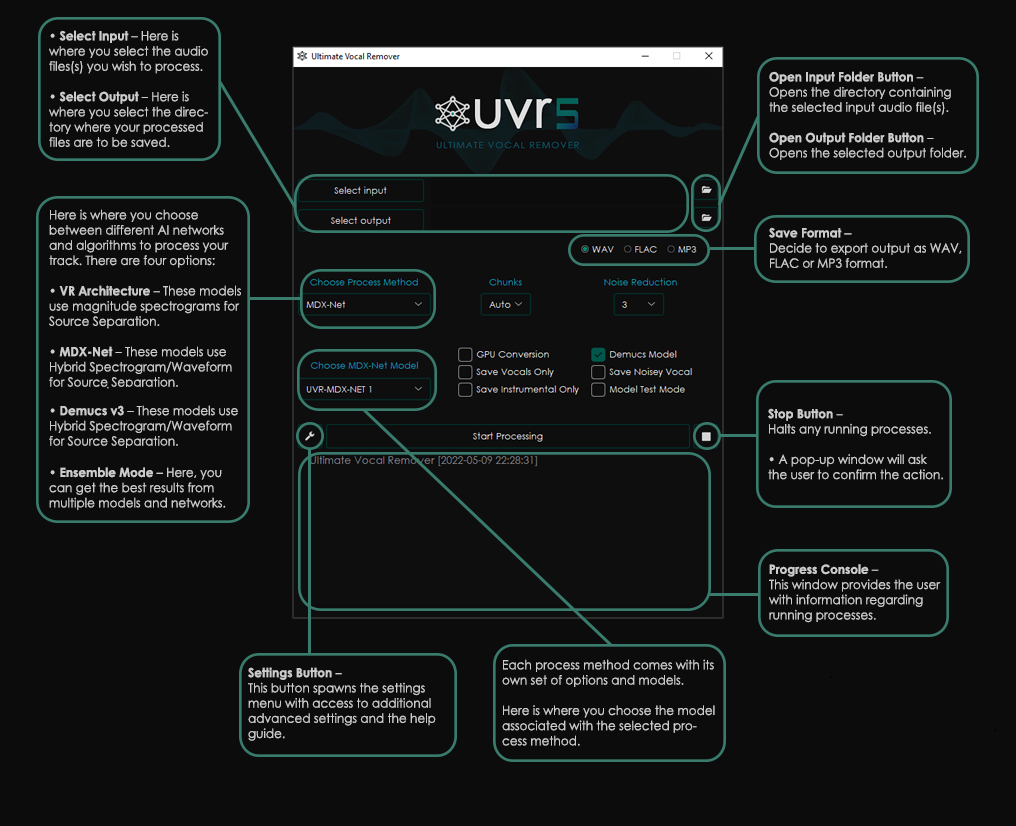

——NovelAI泄露原版前后端部署教程 4chan优化版 naifu

支持 Colab + Linux + win 部署

自带前后端,打开网页就能用,并且可突破 prompt 77 限制

由 4chan 里 Anonymous (https://boards.4channel.org/g/thread/89095460#p89097704) 大佬制作

Nyanko Lepsoni (https://t.me/StableDiffusion_CN/53889) & 炼铜术士 & @exlolicon 等大佬更改支持Colab

PS.默认使用4G模型

(如果是本地搭建的话)最低8G显存可用,但建议10G显存

(补充:更改float16半精准6G显存可能能跑)

如需使用7G模型,可自行下载,更改启动文件里的模型路径来使用

但注意7G模型要求最低16G显存,且不保证正常使用,最好24G以上

不过4G模型、7G模型和官网,差异都不算大,因此不必强求使用7G模型

—超简单colab一键搭建

白嫖colab谷歌服务器无需本地显卡

https://colab.research.google.com/drive/1_Ma71L6uGbtt6UQyA3FjqW2lcZ5Bjck-

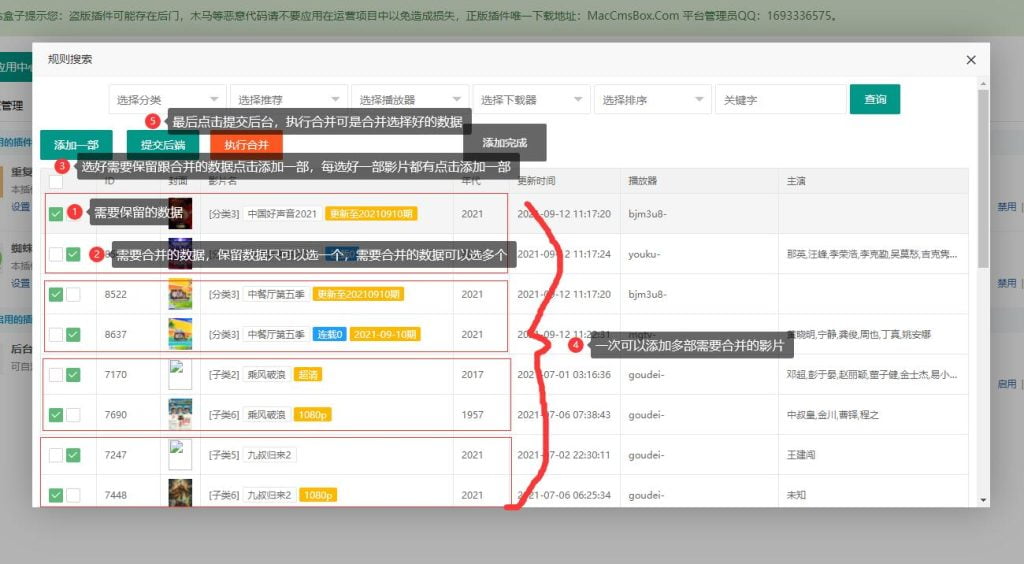

①↑打开由 colab文档链接,登录谷歌账号,左上角,代码执行程序→全部运行

且注意第一步有没有下载成功,如失败请重新运行

②直到第三步,会显示 bore.pub:xxx 和 xxx.trycloudflare.com

两个都是前端地址,不同映射隧道,哪个稳定用哪个

但需要等待出现 Application startup complete / 0.0.0.0:6969 字样出现时再访问

③可选,以 float16 半精准极限运行7G模型

需要结束上方第三步的运行,再运行第四步,依然是等待新地址访问

—Linux 参考 colab 流程即可

—win 下载磁链/打包文件

磁链 magnet:?xt=urn:btih:4a4b483d4a5840b6e1fee6b0ca1582c979434e4d&dn=naifu&tr=udp%3a%2f%2ftracker.opentrackr.org%3a1337%2fannounce

打包 https://pub-2fdef7a2969f43289c42ac5ae3412fd4.r2.dev/naifu.tar

①下载 Python (https://www.python.org/downloads/windows/) ,选中“将 Python 添加到 PATH” 选项来安装

②磁链下载需要解压 program.zip 到当前目录,打包下载已自带解压

③运行 setup.bat 等待环境安装完成

④再运行 run.bat 启动,等待 0.0.0.0:6969 字样出现时访问内网地址

注:由于win环境不一样,同时国内网络不稳定,因此出现错误时建议自行搜索,再无法解决时可到群里询问

请登录后查看评论内容